Die Marktforschung hatte schon immer zwei Seiten: Einerseits die menschliche, psychologische Seite. In jeder Kundenbefragung geht es schließlich um Einstellungen, Erwartungen und Gefühle von Menschen. Aber es gab und gibt immer die methodische, wissenschaftliche Seite der Marktforschung: Umfassende statische Methoden. Klare, wissenschaftliche Herangehensweisen.

Und gerade diese methodische Kompetenz macht ja auch die Stärke von uns als Marktforschungsinstitut aus.

Mit der Disziplin der „Data Science“ ist dabei ein noch größerer Werkzeugkasten für uns hinzugekommen.

Was ist Data Science eigentlich?

Data Science ist mehr als nur “Big Data”. Es ist die Kunst und Wissenschaft, aus Daten belastbare Erkenntnisse zu destillieren – Erkenntnisse, die nicht nur beschreiben, was war, sondern erklären, warum etwas passiert ist, und vorhersagen, was kommen wird.

Das Fundament bilden drei Säulen:

- Statistik liefert die methodische Basis für valide Schlussfolgerungen.

- Programmierung ermöglicht es, mit Datenmengen zu arbeiten, die manuell nicht zu bewältigen wären.

- Und Domain-Expertise sorgt dafür, dass die richtigen Fragen gestellt und die Ergebnisse richtig interpretiert werden.

Der entscheidende Unterschied zur klassischen Statistik? Data Science beschränkt sich nicht auf die Beschreibung dessen, was war. Durch fortgeschrittene Verfahren wie Machine Learning können Muster erkannt, Zusammenhänge identifiziert und Entwicklungen antizipiert werden.

Statt nur zu fragen

“Wie zufrieden sind unsere Kunden?”

können wir fragen:

“Welche Faktoren beeinflussen die Zufriedenheit wirklich?”

und

“Welche Kunden werden in sechs Monaten abwandern?”

Data Science und KI – wo liegt der Unterschied?

KI ist ein Werkzeug innerhalb der Data Science, aber nicht ihr Synonym. Data Science umfasst das gesamte Spektrum: von klassischer Statistik über Machine Learning bis hin zu KI-Anwendungen. Bei Cogitaris nutzen wir KI gezielt dort, wo sie echten Mehrwert bringt – etwa bei der Textanalyse oder Mustererkennung. Aber der Kern bleibt: wissenschaftlich fundierte Methodik, die nachvollziehbar und validierbar ist. KI ist das Werkzeug, Data Science ist die Disziplin.

Warum Data Science gerade auch im B2B-Kontext stark ist:

B2B-Märkte sind komplex. Lange Verkaufszyklen, vielschichtige Entscheidungsprozesse, zahlreiche Stakeholder, individuelle Lösungen statt Massenprodukte. Diese Komplexität spiegelt sich in den Daten wider: CRM-Systeme erfassen Kundeninteraktionen, ERP-Systeme dokumentieren Transaktionen, Webanalytics zeigen digitales Verhalten, Umfragen liefern qualitative Einblicke, Marktdaten zeichnen das große Bild.

- Die Herausforderung: Diese Datenquellen existieren oft isoliert voneinander. Die CRM-Abteilung weiß, wer mit wem gesprochen hat. Die Produktentwicklung kennt die technischen Anforderungen. Das Marketing sieht die Kampagnen-Performance. Aber niemand sieht das Gesamtbild.

Genau hier setzt Data Science an. Moderne Werkzeuge ermöglichen es, diese fragmentierten Datenquellen zu integrieren, zu analysieren und in einem kohärenten Modell abzubilden. Was vor zehn Jahren Wochen an manueller Arbeit bedeutet hätte, geschieht heute in Stunden – und mit einer Präzision, die manuell nicht erreichbar wäre.

- Der Return on Investment ist klar: Bessere Entscheidungen bei gleichzeitig höherer Geschwindigkeit. Statt Quartalsberichte abzuwarten, können Unternehmen kontinuierlich auf Marktveränderungen reagieren. Statt auf Bauchgefühl zu setzen, können sie auf quantifizierte Evidenz bauen.

Die neue Hybrid-Disziplin entsteht

Moderne B2B-Marktforschung ist keine reine Sozialwissenschaft mehr. Sie ist eine Symbiose aus klassischen Forschungsmethoden, Softwareentwicklung und Data Engineering. Das ist kein “entweder-oder”, sondern ein “sowohl-als-auch”.

Die wissenschaftliche Exzellenz bleibt das Fundament. Jedes Projekt muss auf validen, belastbaren Erkenntnissen basieren – über bloßes “Bauchgefühl” hinaus. Die Stichprobe muss repräsentativ sein, die Fragestellungen unverzerrt, die Auswertung methodisch sauber. Aber: Die Technologie erweitert die Möglichkeiten dramatisch.

Softwareentwicklung wird zum integralen Bestandteil. Dashboards werden nicht von IT-Dienstleistern entwickelt, sondern von Marktforschern, die gleichzeitig programmieren können. Datenbanken werden nicht von externen Consultants aufgesetzt, sondern inhouse konzipiert und betrieben. Analysetools werden nicht gekauft, sondern maßgeschneidert entwickelt.

Das Ergebnis: Eine vollständige Kontrolle über die Wertschöpfungskette, von der ersten Konzeption bis zur finalen Erkenntnis. Und die Gewissheit, dass jeder Schritt auf solider wissenschaftlicher Basis steht.

Von der Theorie zur Praxis: Konkrete Data Science-Methoden

Verdeckte Treiber sichtbar machen

Die klassische Marktforschung fragt: “Wie zufrieden sind Sie mit unserem Service?” Die Antwort kommt auf einer Skala von 1 bis 5. Wertvoll – aber unvollständig. Denn die eigentliche Frage lautet: Was genau macht den Unterschied zwischen zufrieden und unzufrieden?

Hier kommen multiple Regressionen ins Spiel. Diese statistischen Verfahren analysieren nicht nur einzelne Faktoren, sondern deren Zusammenspiel. Sie quantifizieren den relativen Einfluss verschiedener Variablen und machen sichtbar, welche Hebel wirklich wirken.

Ein Beispiel aus der Praxis: Ein Maschinenbau-Unternehmen möchte die Kundenzufriedenheit steigern. Die erste Annahme: “Service ist wichtig, also investieren wir mehr in den Support.” Eine Regressionsanalyse kann jedoch zeigen: Die Reaktionszeit hat dreimal mehr Einfluss auf die Zufriedenheit als die Servicequalität selbst. Kunden schätzten schnelle Rückmeldungen höher als perfekte Lösungen, die länger dauerten.

Das Ergebnis: Statt das Support-Team aufzustocken, kann das Unternehmen ein automatisiertes Ticket-System implementieren, das das sofortige Eingangsbestätigungen und Status-Updates sendet. Der Invest ist geringer, der Impact größer. Das ist der Mehrwert datengetriebener Entscheidungen: Ressourcen fließen dorthin, wo sie wirklich wirken.

KI-gestützte Textanalyse – Was Kunden nicht direkt sagen

Geschlossene Fragen liefern quantifizierbare Daten. Aber sie zwingen Kunden in vordefinierte Kategorien. Die wertvollsten Erkenntnisse stecken oft in dem, was Kunden in eigenen Worten formulieren – in offenen Antworten, Bewertungen, Support-Tickets, Kommentaren.

Hier kommt KI ins Spiel – als eines von vielen Data Science Werkzeugen. Natural Language Processing (NLP) nutzt KI-Modelle, um große Mengen unstrukturierter Textdaten zu analysieren. Die Algorithmen erkennen Muster, clustern Themen und bewerten Sentimente – und das in einem Umfang, der manuell unmöglich wäre.

Aber: KI-Einsatz bedeutet bei uns nicht “Black Box”. Jedes KI-gestützte Ergebnis wird methodisch validiert und in den wissenschaftlichen Gesamtkontext eingebettet. Die Algorithmen sind Werkzeuge, keine Orakel.

Mehr zur Textanalyse in der Marktforschung finden Sie hier

Predictive Analytics – Von “Was war?” zu “Was wird sein?”

Klassische Marktforschung ist retrospektiv. Sie beschreibt den Status quo, analysiert vergangene Entwicklungen, erklärt, was war. Predictive Analytics in der modernen Marktforschung, für die auch Cogitaris steht, dreht die Perspektive um: Was wird passieren?

Die Grundlage sind historische Daten – aber nicht als Selbstzweck, sondern als Trainingsdaten für Vorhersagemodelle. Machine-Learning-Algorithmen lernen Muster, identifizieren Frühindikatoren und prognostizieren zukünftige Entwicklungen mit quantifizierbarer Wahrscheinlichkeit.

Churn-Prediction ist ein klassischer Anwendungsfall: Welche Kunden werden in den nächsten sechs Monaten abwandern? Das Modell analysiert Verhaltensänderungen – sinkende Nutzungsfrequenz, reduzierte Bestellmengen, längere Response-Zeiten bei Support-Anfragen. Es erkennt Muster, die menschlich kaum zu erfassen sind, und markiert gefährdete Accounts.

Der Vorteil: Proaktives statt reaktives Handeln. Statt zu reagieren, wenn der Kunde bereits gekündigt hat, können Account Manager präventiv eingreifen – bevor es zu spät ist.

Segmentierung neu gedacht

Traditionelle Kundensegmentierung arbeitet mit vordefinierten Kategorien: Unternehmensgröße, Branche, Umsatz. Das Problem: Diese Kriterien sind oft zu grob, um echte Unterschiede im Verhalten zu erfassen. Zwei Unternehmen aus derselben Branche mit ähnlichem Umsatz können völlig unterschiedliche Bedürfnisse haben.

Clustering-Algorithmen gehen anders vor. Sie analysieren Verhaltensdaten – Kaufmuster, Nutzungsintensität, Feature-Präferenzen, Kommunikationsverhalten – und gruppieren Kunden nach tatsächlichen Gemeinsamkeiten. Die resultierenden Segmente sind nicht mehr theoretisch definiert, sondern empirisch gefunden.

Ein Beispiel: Ein SaaS-Anbieter möchte seine Kunden nach Mitarbeiterzahl segmentieren, und zwar ganz traditionell: Small Business, Mid-Market, Enterprise. Eine Clustering-Analyse kann jedoch fünf völlig andere Gruppen offenbaren: “Power User” (intensive Nutzung aller Features), “Selective Adopters” (fokussiert auf Kernfunktionen), “Growth Seekers” (schnell wachsende Nutzung), “At-Risk” (sinkende Aktivität) und “Dormant” (minimale Nutzung).

Diese verhaltensbasierten Segmente ermöglichen völlig neue Ansätze: Personalisierte Onboarding-Prozesse, zielgerichtete Feature-Kommunikation, präventive Retention-Maßnahmen. Und das Beste: Die Segmente sind dynamisch. Wenn sich das Kundenverhalten ändert, verschiebt sich die Zuordnung automatisch.

Die technologische Infrastruktur einer Marktforschung mit Data Science

Der Markt für Marktforschungs-Software ist groß. Survey-Tools, Dashboard-Plattformen, Analyse-Suites – für fast jeden Anwendungsfall gibt es eine Lösung. Warum also der Aufwand eigener Entwicklung?

Die Antwort liegt in drei fundamentalen Limitierungen von Standardsoftware:

- Methodische Kompromisse. Software diktiert oft, wie eine Analyse durchgeführt wird. Bestimmte statistische Verfahren sind nicht implementiert. Datenformate müssen konvertiert werden. Visualisierungen folgen vordefinierten Templates. Das Ergebnis: Die Methode passt sich der Software an statt umgekehrt. In der Wissenschaft ist das inakzeptabel.

- Black Boxes. Viele Tools nutzen proprietäre Algorithmen. Der Nutzer sieht Input und Output, aber nicht, was dazwischen passiert. Für deskriptive Statistik mag das ausreichen. Für kausale Analysen oder prädiktive Modelle ist es fatal. Wie soll man Ergebnisse validieren, wenn man den Prozess nicht nachvollziehen kann?

- Inflexibilität bei spezifischen Anforderungen. B2B-Märkte sind heterogen. Ein Softwarehersteller hat andere Anforderungen als ein Maschinenbauer, ein Beratungsunternehmen andere als ein Logistiker. Standardsoftware muss den kleinsten gemeinsamen Nenner bedienen. Sie kann nicht auf individuelle Geschäftsmodelle, spezifische Datenstrukturen oder branchenspezifische Fragestellungen eingehen.

Maßgeschneiderte Marktforschungs-Tools als Lösung

Die Alternative: Entwicklung maßgeschneiderter Lösungen. Dashboards, die exakt die Fragen beantworten, die Entscheider haben. KI-Systeme, trainiert auf die spezifische Branche und Domäne. Analysetools, die genau die benötigten Methoden implementieren – nicht mehr, nicht weniger.

Bei Cogitaris bedeutet das: Vollständige Kontrolle über die gesamte Wertschöpfungskette. Von der Konzeption über die Programmierung bis zum Feldmanagement und der finalen Analyse – alles aus einer Hand, alles wissenschaftlich fundiert.

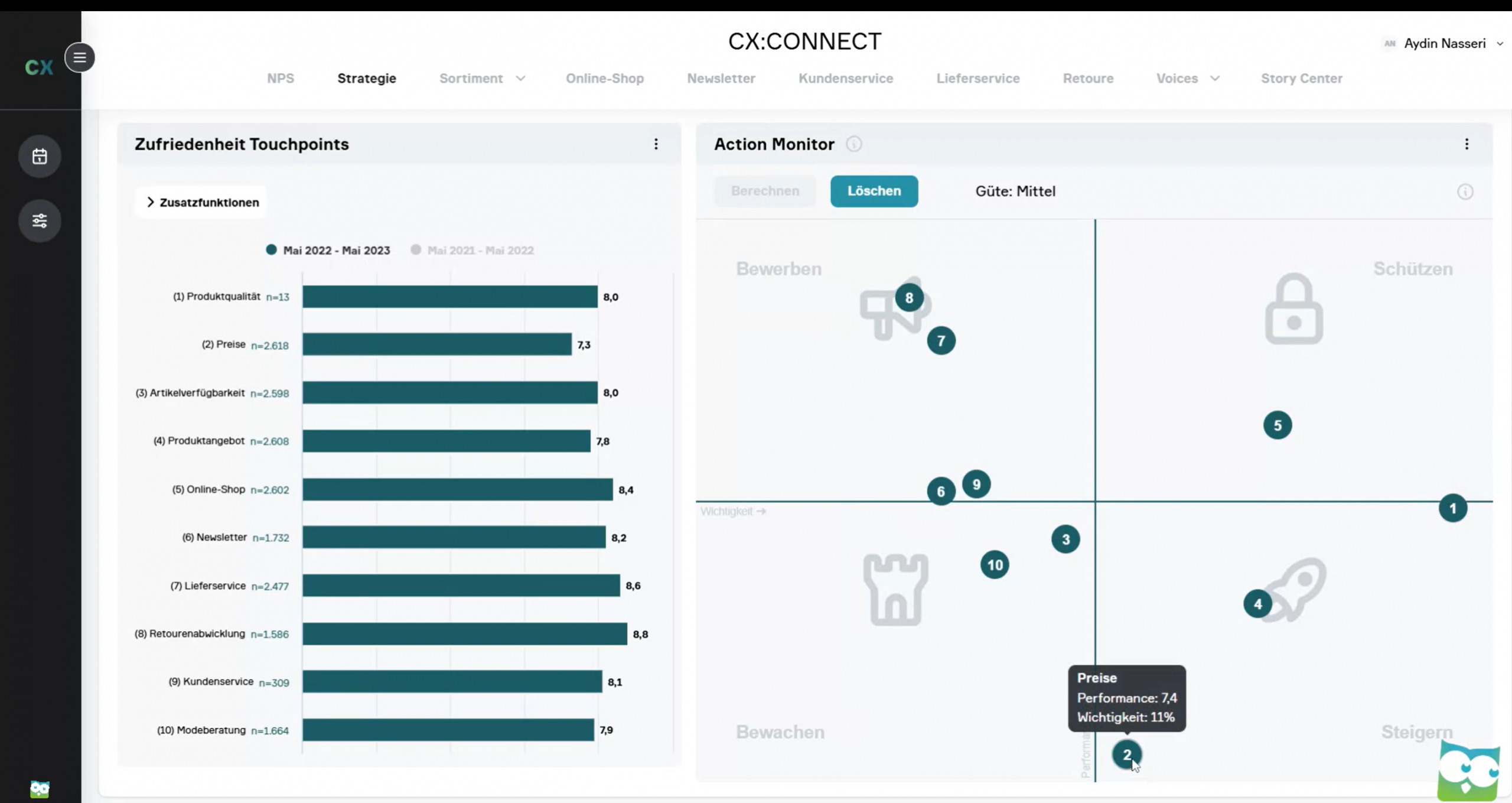

Ein Dashboard ist nicht einfach eine Sammlung von Grafiken. Es ist ein Werkzeug, das strategische Fragen beantwortet. Welche Kundensegmente generieren den höchsten Lifetime Value? Wo drohen Abwanderungen? Welche Produktfeatures treiben die Zufriedenheit? Das Dashboard visualisiert nicht nur Daten, sondern kontextualisiert sie – mit Benchmarks, Trends, Alerts.

KI-Systeme werden nicht von der Stange gekauft, sondern auf die spezifische Aufgabe trainiert. Ein NLP-Modell für einen Maschinenbauer muss technische Terminologie verstehen. Ein Modell für einen Dienstleister braucht Sensitivität für Service-Qualität. Die Domänen-Expertise fließt direkt in das Training ein.

Analysetools implementieren exakt die Methoden, die für die Fragestellung relevant sind. Keine überfrachteten Interfaces mit hundert Features, von denen 95 nicht benötigt werden. Stattdessen: Fokussierte Werkzeuge, die das tun, was sie sollen – und das gut.

Data Engineering als Enabler

Die beste Analyse nützt nichts, wenn die Datengrundlage mangelhaft ist. Data Engineering – die Disziplin, die sich mit Datenerfassung, -integration und -aufbereitung beschäftigt – ist der unsichtbare Enabler moderner Marktforschung.

Die Herausforderung: Daten kommen aus multiplen Quellen. CRM-Systeme, ERP-Plattformen, Umfrage-Datenbanken, Marktdaten-Anbieter, Web-Analytics. Jede Quelle hat ihre eigene Struktur, ihre eigenen Formate, ihre eigene Logik. Sie zu einem kohärenten Datensatz zu verbinden, ist komplex – aber essentiell.

Automatisierte Pipelines ersetzen manuelle Exports. Statt dass jemand monatlich CSV-Dateien aus verschiedenen Systemen herunterlädt, zusammenführt und bereinigt, geschieht das automatisch. Die Pipeline läuft kontinuierlich, integriert neue Daten in Echtzeit, identifiziert Anomalien und gewährleistet Datenqualität.

Datenqualität und -governance sind keine Nebenaspekte, sondern Grundlage. Fehlende Werte, Duplikate, inkonsistente Formatierungen – solche Probleme müssen systematisch adressiert werden. Sonst ist das Ergebnis egal wie ausgefeillt die Analyse ist: Garbage in, garbage out.

Das Resultat: Real-time Insights statt Quartalsberichte. Entscheider müssen nicht drei Monate warten, bis die nächste Auswertung vorliegt. Sie sehen kontinuierlich, wie sich relevante Metriken entwickeln – und können entsprechend schnell reagieren.

Von Daten zu Entscheidungen: Die neue Übersetzungsleistungen

Die technische Exzellenz ist das eine. Die praktische Anwendbarkeit das andere. Zwischen beiden liegt eine entscheidende Hürde: das Übersetzungsproblem.

Data Scientists sprechen die Sprache der Algorithmen. Sie denken in Features, Parametern, Metriken, Modellen. Entscheider denken in Strategien, Budgets, Ressourcen, Ergebnissen. Die Brücke zwischen beiden Welten zu schlagen, ist keine technische, sondern eine kommunikative Herausforderung.

Ein Beispiel: Ein Churn-Prediction-Modell identifiziert mit 85% Genauigkeit Kunden, die in den nächsten sechs Monaten abwandern werden. Technisch beeindruckend. Aber was bedeutet das konkret für einen Account Manager? Welche Kunden genau? Was soll er tun? Mit welcher Priorität?

Erkenntnisse müssen handlungsrelevant aufbereitet werden. Das Dashboard zeigt nicht nur “KPI sinkt um 12%”, sondern “warum” (welche Faktoren treiben den Rückgang?) und “was tun” (welche Maßnahmen versprechen den größten Hebel?). Das ist der Unterschied zwischen Information und Insight.

Handlungsrelevante Aufbereitung

Wie sieht handlungsrelevante Aufbereitung konkret aus?

- Dashboards mit Kontext: Nicht einfach Zahlen und Grafiken, sondern Interpretationshilfen. Ein Rückgang der Zufriedenheit ist nur dann aussagekräftig, wenn klar ist: Betrifft er alle Segmente oder nur bestimmte? Ist es ein saisonaler Effekt oder ein struktureller Trend? Liegt er über oder unter dem Branchen-Benchmark? Kontext macht aus Daten Erkenntnisse.

- Automatisierte Alerts: Entscheider können nicht permanent Dashboards monitoren. Alerts informieren proaktiv über relevante Veränderungen. “Segment X zeigt 20% Rückgang in Nutzungsintensität” – mit direktem Link zu den Details und empfohlenen Maßnahmen. Die Information kommt zum Entscheider, nicht umgekehrt.

- Szenario-Simulationen: “Was passiert, wenn wir Preis X um Y% erhöhen?” “Wie verändert sich die Retention, wenn wir Feature Z einführen?” Simulationen machen Entscheidungen transparent. Sie zeigen nicht nur eine Empfehlung, sondern die Konsequenzen verschiedener Optionen – mit quantifizierten Wahrscheinlichkeiten und Risiken.

- Der Alltags-Test: Kann ein Entscheider morgen anders handeln als heute? Das ist der Lackmustest für handlungsrelevante Marktforschung. Wenn die Antwort “Nein” lautet, war es nur Information. Wenn die Antwort “Ja” lautet, war es Insight.

Demokratisierung der Marktforschung durch Technologie

Traditionell war Marktforschung ein Privileg des Managements. Reports gingen an die Führungsebene, Entscheidungen wurden top-down getroffen, die operative Ebene erfuhr von Erkenntnissen allenfalls indirekt.

Moderne Technologie ermöglicht Demokratisierung. Dashboard-Systeme ohne Nutzerkostenmodell bedeuten: Jeder im Unternehmen, der Zugang braucht, bekommt ihn. Der Account Manager sieht die Gesundheits-Scores seiner Kunden. Der Produktmanager analysiert Feature-Nutzung. Der Marketing-Manager trackt Kampagnen-Performance. Alle arbeiten mit denselben Daten, in Echtzeit, ohne Verzögerung.

Das ist mehr als ein technisches Feature. Es ist ein kultureller Shift. Kundenzentrierung wird nicht mehr als abstraktes Unternehmensziel verkündet, sondern als konkrete Handlungsmaxime gelebt. Wenn jede Abteilung direkten Zugang zu Kundenerkenntnissen hat, fließen diese automatisch in Entscheidungen ein – vom strategischen Invest bis zur operativen Umsetzung.

Customer Centricity wird vom Abteilungsthema zur Unternehmenskultur. Und genau das ist der eigentliche Mehrwert moderner Marktforschung: Nicht nur bessere Daten, sondern bessere Entscheidungen auf allen Ebenen.

Ausblick: Die weitere Entwicklung von Data Science in der Marktforschung

Data Science in der Marktforschung ist kein statisches Feld. Die Entwicklung beschleunigt sich, neue Methoden entstehen, bestehende werden verfeinert. Wohin geht die Reise?

Integration statt Isolation

Marktforschung wird zunehmend Teil des operativen Systems. Nicht mehr eine separate Disziplin, die Studien durchführt und Reports produziert, sondern ein integrierter Bestandteil der Unternehmenssteuerung. Erkenntnisse fließen direkt in CRM-Systeme, Marketing-Automation, Produktentwicklung. Die Grenze zwischen “Forschung” und “Anwendung” verschwimmt.

Automatisierung von Routineanalysen

Viele Analysen, die heute noch manuell durchgeführt werden, laufen künftig automatisch. Trendanalysen, Segmentierungen, Standard-Reports – Algorithmen erledigen das zuverlässiger und schneller als Menschen. Das Ergebnis: Mehr Zeit für strategische Interpretation, für die Fragen, die Kreativität und Domänen-Expertise erfordern.

Die KI-Evolution: Von Descriptive zu Prescriptive

Die aktuelle Generation von Data Science fokussiert primär auf descriptive und predictive Analytics. Was war? Was wird sein? Die nächste Stufe ist prescriptive Analytics: Was sollten wir tun? KI-Systeme, die nicht nur Muster erkennen und Prognosen liefern, sondern konkrete Handlungsempfehlungen generieren – optimiert für definierte Ziele, unter Berücksichtigung von Constraints und Risiken.

Das ist keine Science-Fiction. Die technologischen Grundlagen existieren bereits. Die Herausforderung liegt in der methodischen Validierung und ethischen Rahmung. Aber die Richtung ist klar.

Die Vision: Marktforschung als Betriebssystem

Langfristig wird Marktforschung nicht mehr als Projekt verstanden, sondern als kontinuierlicher Prozess. Ein Betriebssystem für kundenzentrierte Entscheidungen, das permanent läuft, sich selbst aktualisiert, lernt und optimiert.

Entscheider fragen nicht mehr: “Wann kommt die nächste Studie?” Sie fragen: “Was sagen die aktuellen Daten?” Und sie bekommen Antworten – nicht in Wochen, sondern in Sekunden.

Fazit:

Data Science verändert nicht nur, wie wir Marktforschung betreiben – sie verändert, was Marktforschung leisten kann. Die Kombination aus wissenschaftlicher Exzellenz und technologischer Innovation ermöglicht Erkenntnisse, die vor wenigen Jahren undenkbar waren.

Sie möchten in Ihren Projekten auch von Data Science in der Marktforschung profitieren? Wir stehen an Ihrer Seite: Jetzt Termin vereinbaren